La última guaracha tecnológica

Sumario:

Antes de comenzar a escribir, ya sé que estoy metiéndome en contramano. Y no sólo porque vaya en contra de los intereses comerciales de algunas compañías, sino porque, casi con toda seguridad, chocaré frontalmente con la opinión de algunos compañeros. Pero aún así, y siendo consciente de que alguno me puede tachar de conservador o […]

Antes de comenzar a escribir, ya sé que estoy metiéndome en contramano. Y no sólo porque vaya en contra de los intereses comerciales de algunas compañías, sino porque, casi con toda seguridad, chocaré frontalmente con la opinión de algunos compañeros. Pero aún así, y siendo consciente de que alguno me puede tachar de conservador o inmovilista, no quiero dejar de expresar mi preocupación por una tendencia muy extendida en los servicios de Radiofísica / Radioterapia: la de dejarnos seducir, quizás con demasiada ligereza, con cualquier innovación que se ofrezca en los aceleradores de uso clínico. En otras palabras: que en lugar de que seamos los profesionales los que marquemos las tendencias que debería seguir la evolución de las unidades de irradiación, en función de las necesidades que vayamos encontrando en nuestra práctica asistencial e investigadora, sean las casas comerciales las que nos «impongan» sus avances tecnológicos, cuya rentabilidad en términos de una mejora apreciable de los tratamientos es, en algunos casos, cuestionable. No estoy en contra de que los equipos evolucionen, no quiero que me malinterpretéis. Lo que pongo en duda es la utilidad de ciertas funciones que incluyen algunos equipos en aras de una hipotética mayor calidad de los tratamientos y que, en contrapartida, aportan mayor complejidad a este proceso, cuando no un aumento de dosis parásitas indeseables para el paciente.

Os pondré un ejemplo: cuando apareció la técnica de la liberación del tratamiento mediante ventana deslizante, o sliding windows como se la conoce normalmente, se vendía como que la distribución de dosis iba a ajustarse perfectamente a los requerimientos que se impusieran desde el punto de vista de la prescripción dosimétrica del tratamiento. Era, según los que la vendían, la prueba irrefutable de la supremacía de los tratamientos continuos frente a los discretos. Lo que no se decía es algo que a ningún físico se le debería escapar, y es que la distribución de fluencia no coincide con la de dosis. Existe un mecanismo llamado dispersión, que hace que estas dos magnitudes no mantengan la proporcionalidad. Y además, por si fuera poco, el cálculo que realiza el sistema que simula el tratamiento, inevitablemente tiene que ser discreto, lo que hace que la distribución real de dosis se aleje en mayor o menor medida de la teórica. Y todo esto a costa de liberar mucha más fluencia primaria (habitualmente un factor 3 ó 4 veces superior) para suministrar la misma dosis, lo cual supone un importante incremento de la radiación de fuga que baña totalmente al paciente.

Esta carrera vertiginosa por ofrecer nuevas funcionalidades a los aceleradores clínicos, cada vez más sofisticadas y complejas tiene fundamentalmente dos frentes abiertos en la actualidad: Uno consiste en suprimir el filtro aplanador del haz. En el otro se trata de variar durante el tratamiento todo aquello que sea susceptible de cambio (velocidad de gantry, colimador, láminas, tasa de dosis…).

La supresión del filtro aplanador no es en sí misma un inconveniente, pero puede ser preocupante comenzar a emplear esta opción sin analizar y tener cuidadosamente en consideración las implicaciones que esto conlleva y que conviene no perder de vista si queremos asegurar la calidad de los tratamientos. Por un lado está el hecho de que en un haz de fotones “convencional”, es decir, con filtro aplanador, la componente de baja energía del espectro queda suprimida, hecho que no sucede en un haz sin filtro o FFF (flattening filter free), lo que puede incrementar considerablemente la irradiación de la piel.

Por otro lado, si el tamaño de la zona que se quiere irradiar no es suficientemente pequeño, la uniformidad de la dosis ha de ser modulada mediante el colimador multiláminas para suprimir el pico de intensidad de la parte central del haz. En otras palabras, tendríamos que generar un filtro aplanador virtual. Esto implica que la alta tasa de dosis que se consigue con un haz FFF pierde su sentido, ya que para suministrar la misma dosis se necesitaría mayor fluencia primaria (mayor número de Unidades Monitor) que en un haz convencional.

Además, está el hecho de que el incremento de la tasa de dosis lleva a los instrumentos de medida a una zona en la que los efectos de recombinación iónica son importantes y no resultan fáciles de tener en cuenta de forma apropiada usando los protocolos de dosimetría actualmente aceptados. Esto implica verificar la validez del método de las dos tensiones (http://iopscience.iop.org/0031-9155/52/2/N01) mediante la medida previa de los gráficos de Jaffé (donde se representan los valores empíricos obtenidos de la inversa de la carga colectada frente al inverso del voltaje aplicado) o bien emplear una expresión general cuyos coeficientes dependen de la cámara de ionización empleada (1998, Phys. Med. Biol. 43 2033). Análogamente, las curvas de deposición de dosis y los perfiles deben corregirse por este efecto, lo cual no es una tarea fácil con los algoritmos implementados en los sistemas comerciales 3D de análisis de haces. Este fenómeno puede llegar a tener una relevancia muy significativa si pensamos usar los haces FFF para la Radiocirugía estereotáxica, bien sea craneal o extracraneal, en la que la proximidad de órganos críticos y las dosis suministradas hacen que la caracterización de la penumbra del haz sea crítica.

Y por último, aunque algunos trabajos apuntan a que la influencia no parece que sea importante, aún no tenemos datos “in vivo” contrastados relativos al efecto radiobiológico de estas tasas de dosis tan elevadas (unidas a dosis por sesión también altas), no en cuanto a la muerte celular en el volumen blanco, sino relativos al daño crónico del tejido sano circundante.

Evidentemente, ninguno de los factores señalados anteriormente, atribuibles a la supresión del filtro aplanador, constituye una desventaja per se, pero introducen una dificultad adicional considerable, cuya rentabilidad en términos de número de pacientes beneficiados y mejora objetiva del tratamiento hay que considerar cuidadosamente.

Por otro lado, en cuanto a la variación simultánea durante la irradiación de la tasa de dosis, la velocidad del gantry, de las láminas y del giro del colimador, no hace falta ser un visionario para comprender que asegurar la calidad cuando hay tantos parámetros que controlar, podría multiplicar el tiempo necesario para realizarlo. Esta realidad ya relativiza bastante la ventaja de los tratamientos dinámicos en términos de un posible acortamiento de la duración de cada sesión ya que, en un flujo de trabajo normal, es muy improbable que por disminuir ligeramente este factor pueda aumentarse significativamente el número de pacientes tratados mientras que, en contrapartida, las franjas horarias dedicadas a control de calidad tendrían que incrementarse consecuentemente. Por otro lado, y contrariamente a lo que he llegado a escuchar en alguna ocasión, no es cierto que los tiempos ligeramente superiores de un tratamiento estático comprometan su eficacia desde un punto de vista radiobiológico. Y además, tenemos que considerar que el tratamiento teórico que se ha diseñado en el planificador puede variar significativamente con respecto al que se libera realmente debido a la discretización que se realiza en el cálculo. No estaría de más recordar aquí que lo digital ha demostrado siempre ser superior a lo analógico, en términos de reproducibilidad y robustez.

Evidentemente, existen soluciones teóricas complejas que resuelven los condicionamientos dosimétricos de la prescripción del tratamiento teniendo en cuenta todos estos parámetros que entran en juego, pero -perdonadme si frivolizo un poco- es como si pretendiéramos ajustar un conjunto de N puntos que podrían tener un comportamiento lineal, mediante un polinomio de grado N-1. Como es lógico, la función resultante pasará exactamente por todos los puntos, pero no olvidemos que, en el caso que nos ocupa, cada punto corresponde a un constraint en la prescripción y que, por tanto, está inevitablemente afectado por una incertidumbre, con lo que este ajuste tan “ajustado” deja de tener sentido físico. Existen actualmente algunas iniciativas comerciales para aplicar un criterio más racional a la solución del diseño del tratamiento, como puede ser la Optimización por Apertura Directa (DAO), donde se consideran restricciones geométricas iniciales que hacen la optimización mucho más eficiente. No obstante y desafortunadamente, no son muchas compañías las que apuestan por estas alternativas.

Resumiendo y enlazando con el comienzo de este post, creo que no conviene perder nunca de vista que la compra de una máquina que incorporase estos avances tecnológicos podría tener sentido en un centro que contara con varios aceleradores más “normalitos”. Sin embargo, el incremento de precio asociado a la inclusión de estas funciones adicionales es más que cuestionable en hospitales pequeños donde la labor de los profesionales implicados -respetabilísima y digna, como no podía ser de otro modo- estará dedicada, en un porcentaje muy elevado, a tratamientos más convencionales. Esto exige, en estos casos de forma particularmente crítica, un estudio previo de la utilidad que se piensa obtener de este coste adicional.

A los que, sin estar directamente relacionados con la Radioterapia, hayáis sido capaces de llegar hasta aquí en la lectura de este trabajo, creo que os debo una disculpa (y quizás un aplauso) porque, a pesar de mis esfuerzos, no he podido evitar un tono que quizás sea demasiado técnico. No obstante, me gustaría que al final os quedara la idea de que, antes de adquirir una nueva guaracha tecnológica, es preciso ser conscientes de para qué sirve, si es realmente necesaria en cada caso particular, si es posible obtener resultados similares con estrategias más simples, qué porcentaje de pacientes van a poder beneficiarse de ella y si vamos a disponer de los recursos necesarios para poder rentabilizarla.

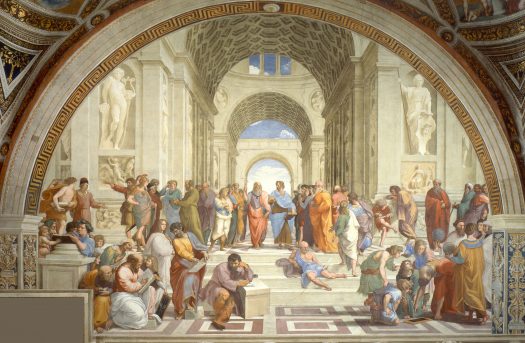

No permitamos que el marketing asociado a esta avalancha tecnológica que se basa, en gran medida, en presentar como soluciones “mejores” las más complejas, haga que podamos encontrarnos ante una versión radioterápica de El Retablo de las Maravillas, en la que, como en el entremés de Cervantes, no nos atrevamos a expresar nuestras discrepancias por miedo a parecer ignorantes.