“Big Data”, o la estadística que no se olvida de los individuos

Sumario:

Vivimos en una época en la que generamos miles y miles de datos en todos los ámbitos de nuestras vidas, a velocidad de vértigo y de forma masiva. Los teléfonos móviles están continuamente registrando nuestra posición, así como la forma en que nos movemos. Estamos viviendo la aparición de los wearables, pequeños aparatos que pronto […]

Vivimos en una época en la que generamos miles y miles de datos en todos los ámbitos de nuestras vidas, a velocidad de vértigo y de forma masiva. Los teléfonos móviles están continuamente registrando nuestra posición, así como la forma en que nos movemos. Estamos viviendo la aparición de los wearables, pequeños aparatos que pronto llevaremos encima, y que cuantifican parámetros como la actividad física, la frecuencia cardíaca o la presión arterial. Otra información que la tecnología ya ha puesto al alcance de nuestra mano es la genética. En los Estados Unidos se están popularizando los tests que permiten el análisis genético avanzado, bien por identificación de marcadores o por secuenciación completa, a costes que pueden considerarse ya como razonables.

El ámbito de la medicina no es ninguna excepción: tanto en hospitales como en centros médicos se genera una gran cantidad de información de diversa índole de forma continua. Recientemente, en una entrevista TED, uno de los dos fundadores de Google, Larry Page, afirmaba que “si la gente pudiese compartir sus historias clínicas de forma anónima, y si los médicos pudieran tener acceso a esta información online y conectarla con la de sus propios pacientes, podrían salvarse hasta 100.000 vidas al año”. En consonancia con Larry Page, múltiples voces a lo largo de todo el mundo están mostrando grandes esperanzas con respecto a las posibilidades de este fenómeno, conocido como “big data”, en todos los ámbitos imaginables. Aunque también es cierto que tampoco faltan los que consideran a todo este asunto como el último gran bluf tecnológico.

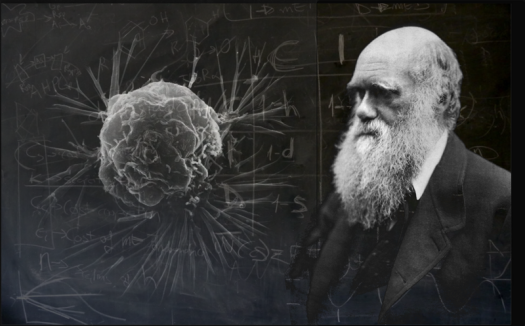

Una de las mayores esperanzas del big data es el papel que podría jugar en la consecución del ideal de la medicina personalizada. En realidad, la medicina siempre ha sido personalizada: los médicos siempre se han centrado en lo que es mejor para cada paciente en particular. Pero se trata de ir más lejos tratando de alcanzar el mayor grado de personalización, y, por tanto, un diagnóstico y tratamiento lo más acorde posible con las características individuales. En el caso particular del cáncer, sabemos ahora que los tumores y pacientes son menos homogéneos de lo que siempre habíamos supuesto. Un tratamiento idéntico puede tener resultados muy diferentes en pacientes con el mismo tipo de tumor. En definitiva, el objetivo es pasar de una medicina basada en poblaciones a una medicina basada en el individuo.

Pero esto no es nada fácil, tal como nos explicó Víctor Barrondo en su post “Auge y caída de la medicina basada en evidencia”. El sistema vigente para extraer evidencia científica a través de los ensayos clínicos presenta serias limitaciones. Una de la más importantes es que los resultados no son fácilmente trasladables a los individuos y a sus condiciones particulares. En oncología, los pacientes que participan en los ensayos clínicos apenas representan un 3%-5% de todos los pacientes de cáncer; en radioterapia, esta cifra puede ser aún inferior. Esto significa que cuando un oncólogo decide tratar a un paciente individual basándose en los resultados de un ensayo clínico, es altamente probable que dicho paciente no presente las mismas características clínicas que los pacientes en la cohorte del ensayo [Lambin, 2013]. Además, debido a la velocidad del desarrollo tecnológico actual, la realización de los clásicos ensayos clínicos randomizados para comparar distintas opciones de tratamiento frente a un gold standard se está convirtiendo en una tarea casi imposible de abordar.

En la era de la medicina personalizada, tanto los pacientes como sus enfermedades se ven de forma individual [Maitland, 2011].

El big data, como concepto, implicaría recoger, almacenar, integrar y analizar todas las características relevantes de todos los pacientes tratados así como de los tratamientos administrados, y finalmente, los resultados obtenidos. ¿Cuáles serían estas características?

- Características demográficas: edad, sexo…

- Características clínicas: el estado general del paciente, resultados de diversos análisis, imágenes adquiridas para el diagnóstico…

- Características biológicas y moleculares: información genética (biomarcadores moleculares)

- Características del tratamiento o la intervención: medicación, dosis, patrón de administración…

Imaginemos por un momento que esta base de datos gigantesca, compartida entre todos los hospitales, estuviera a nuestro alcance. Mediante los algoritmos adecuados el procesamiento multifactorial de toda esta información podría llevarnos, potencialmente, a obtener predicciones para nuevos pacientes adaptadas a sus características particulares, y en función de las diferentes opciones de tratamiento. Y todo ello, gracias a los datos recogidos como mero producto de la práctica clínica diaria. Pero esto, no lo olvidemos, es un escenario ideal, ¿cómo de lejos nos encontramos?

El primer paso sería conseguir el volumen y la diversidad necesaria de datos, lo cual sólo es factible si las bases de datos se comparten entre el mayor número posible de centros. Ello implica superar no pocas barreras, entre las cuales podemos destacar:

- barreras administrativas (esfuerzos para capturar y compartir los datos),

- barreras legales (problemas con la privacidad, autoría de los datos),

- barreras tecnológicas.

Por ejemplo, pensemos que cada hospital recoge los datos siguiendo sus esquemas y plataformas particulares, y muy posiblemente con una estructura y un formato inadecuados, ¿cómo va a ser posible entonces compartir los datos? Una de las soluciones está en el concepto de “interoperabilidad semántica”, que se define como la capacidad de las máquinas de entenderse entre sí. En esta línea, la clínica de los Países Bajos MAASTRO ha liderado el proyecto euroCAT, en el que se ha desarrollado una infraestructura tecnológica que permite que las bases de datos de cinco hospitales (Maastricht, Lieja, Aquisgrán, Eindhoven y Hasselt) sean inter-operables, sin necesidad de extraer físicamente los datos de los hospitales, y permaneciendo bajo el control de cada centro. Otro problema importante es que los datos que se recogen de forma rutinaria en la práctica clínica son de una calidad inferior a la de los ensayos clínicos: pueden ser contradictorios, estar sesgados e incluir incorrecciones. Aunque muchos problemas pueden mitigarse en mayor o menor medida gracias al gran volumen de información recogida, va a ser esencial establecer criterios de estandarización en los datos que se vayan a recopilar en la rutina diaria.

El siguiente problema es el de cómo extraer valor de toda esta información. ¿De qué herramientas disponemos? Gracias a los avances en modelización estadística y computación y otras áreas afines como la inteligencia artificial, hoy día tenemos a nuestro alcance una gran variedad de técnicas para extraer conocimiento a partir de conjuntos de datos, bien en forma de modelos matemáticos, bien en forma patrones, o mediante otro tipo de representaciones. El aprendizaje automático o machine learning es un área que estudia cómo capacitar a las máquinas para que aprendan a partir de una serie de datos. La idea es que, a partir de un conjunto de datos de entrenamiento, se va alimentando un algoritmo que es capaz de ir aprendiendo de las observaciones; una vez entrenada, la máquina clasifica ejemplos nuevos con precisión. La clasificación será mejor cuantos más datos (más pacientes), y más diversos (más variables), tengamos. En el contexto del big data, todo apunta a que los modelos de aprendizaje automático van a jugar un papel esencial. La idea es integrar estos modelos en sistemas automáticos de ayuda a la decisión, capaces de combinar datos de naturaleza variada y hacer un balance entre las múltiples opciones de tratamiento. En el ámbito de la radioterapia, ya existen publicaciones que presentan modelos predictivos para distintos resultados como la probabilidad de supervivencia, patrones de recurrencia y toxicidad, y para distintos tipos de cáncer. La página web creada por investigadores de la clínica MAASTRO proporciona modelos para cáncer de pulmón, recto, y cabeza y cuello.

Pero existen otras herramientas distintas para trabajar con big data. La investigadora P. Lum trabaja analizado datos de cáncer empleando una novedosa tecnología basada en el análisis topológico de los datos (“topological data analysis”, o TDA), desarrollada por tres matemáticos de la Universidad de Stanford, y comercializada por la empresa Ayasdi [vídeo explicativo]. La idea es tratar de comprender los datos empleando nociones de topología, que es la rama de las matemáticas que estudia las propiedades del espacio. Partamos de una base de datos extremadamente compleja: las observaciones (léase pacientes) se tratan como si fueran puntos en un espacio de muchísimas dimensiones, y se construye una red topológica agrupando los puntos que son similares en nodos. Los nodos están interconectados, de modo que se forma una red cuya forma tiene un significado. Como cada nodo representa a un conjunto de puntos, la red proporciona una versión comprimida de la base de datos multidimensional, y se puede explorar para descubrir características que de otra forma serían muy difíciles de ver.

El TDA, aplicado a grandes bases de datos con información genética de pacientes de cáncer de mama, ha resultado ser eficaz para hallar subgrupos de pacientes con características genéticas particulares y con una mayor supervivencia al resto.

Lum ha aplicado el TDA a una base de datos sobre cáncer de mama generada a lo largo de 12 años en el Instituto de Cáncer de los Países Bajos (NKI), y ha hallado un subgrupo de pacientes de cáncer [Lum, 2012] con mayor supervivencia que los demás, y que exhiben unas características genética particulares (véase imagen) desconocidas anteriormente.

Nos encontramos en una época de transición de la medicina basada en poblaciones hacia la medicina personalizada y se nos presentan no pocos desafíos. Para conseguirlo, la tradicional investigación basada en ensayos clínicos deberá evolucionar y fusionarse con metodologías más ágiles capaces de explotar grandes cantidades de información, y hacerlo además en poco tiempo. Ya existen propuestas en este sentido, como el sistema de aprendizaje rápido (rapid learning) (figura) que integran todos los elementos que aquí se han mencionado y en el que el big data juega un papel central.

La metodología de Rapid learning, propuesta por Lambin y Roelofs, funcionaría en paralelo con los ensayos clínicos convencionales. Como destacan los autores ambos enfoques son necesarios y complemetarios [Lambin, 2013].

De la mano del big data se están desarrollando las tecnologías y enfoques adecuados para el manejo y la extracción de valor de grandes cantidades de datos. Es posible que no estemos tan lejos del día en que incluso los datos que nuestros wearables empezarán recogiendo de forma lúdica se integren con nuestra información clínica y nuestro perfil genético, y pasen a jugar un papel activo en nuestro diagnóstico y tratamiento. Los beneficios potenciales de la unificación de toda esta información en bases de datos comunes y su explotación son enormes, y representa una oportunidad que no deberíamos dejar escapar.

Referencias

- [Maitland, 2011] Clinical Trials in the Era of Personalized Oncology, Maitland M L, Schilsky R L, CA CANCER J CLIN 2011; 61:365-381

- [Lambin, 2013] ‘Rapid Learning health care in oncology’ -An approach towards decision support systems enabling customised radiotherapy’, Lambin P et.al. Radiotherapy and Oncology 109 (2013): 159-164

- [Lambin, 2012] Predicting outcomes in radiation oncology -multifactorial decision support systems, Nature Reviews

- [Lum, 2012] Patient Stratification using Topological Data Analysis and Iris, [poster]

- [Nicolau, 2010] Topology based data analysis identifies a subgroup of breast cancers with a unique mutational profile and excellent survival, Nicolau M et.al. PNAS (2011), 108 (17) 7765-7270 link